Bereits vor einigen Wochen habe ich mich an dieser Stelle etwas eingehender mit dem Zusammenhang zwischen der wirtschaftlichen Stärke und dem sportlichen Erfolg von Fußballklubs im Allgemeinen und im Speziellen bei einer genaueren Untersuchung der Verhältnisse im österreichischen Spitzenfußball. Wir konnten dabei sehen, dass im Falle der österreichischen Budnesliga der Durchschnittsmarktwert eines Teams als Indikator für seine wirtschaftliche Stärke mehr als die Hälfte der Varianz der erreichten Punkte erklärt; sportlicher Erfolg ist also in großem Maße von den dahinterstehenden wirtschaftlichen Möglichkeiten abhängig, wird aber nicht komplett von diesen determiniert.

Modelle, die derartige Zusammenhänge untersuchen, eignen sich auch, um Prognosen über zukünftige Leistungen herzustellen. Die Idee dahinter ist, dass ein Faktor (wie beispielsweise die wirtschaftlichen Möglichkeiten eines Klubs) hoch mit einem anderen korrelierte, wird das auch in Zukunft der Fall sein. Aufgrund der Ausprägung des ersten Faktors können wir daher mit einer gewissen Wahrscheinlichkeit diejenige des anderen (zum Beispiel Punkte am Saisonende) vorhersagen.

Da die genaue Anzahl der Punkte sicher schwer vorherzusagen ist, ist es sinnvoll, nicht nur den prognostizierten Wert anzugeben, sondern auch Konfidenzintervalle. Diese geben den Bereich an, in dem der prognostizierte Wert mit einer gewissen Wahrscheinlichkeit (in diesem Fall 95%) liegt. Werte darunter oder darüber deuten dementsprechend eine außergewöhnlich gute oder schwache Saison an.

Graphik 1 zeigt diese Prognose für die Teams der österreichischen Bundesliga für die Saison 2015/16 (inklusive Konfidenzintervallen in Schwarz gehalten) und vergleicht diese Prognose mit den tatsächlich erreichten Punkten (die in Rot in die Graphik eingefügt sind). Geordnet sind die Teams nach ihrem tatsächlichen Abschneiden.

|

| Graphik 1 |

Zu Beginn sehen wir, dass Meister Salzburg trotz gewisser sportlicher Probleme und des Verschleißes gleich dreier Cheftrainer in der ersten Saisonhälfte eine Punktlandung gelang. Man holte genau so viele Punkte wie das Modell prognostizierte. Dahinter folgen drei Teams aus Wien und Umgebung, die weit besser abschnitten als man vor der Saison annehmen konnte; alle drei liegen sogar über dem Ende ihrer Konfidenzintervalls, allen voran das Sensationsteam aus der Südstadt. Aber auch Rapid und die Austria können mit dem sportlichen Abschneiden in der Vorsaison zufrieden sein und werden Schwierigkeiten haben, in der folgenden Saison diese Punkteausbeute zu bestätigen.

Dahinter folgt mit Sturm eine der gemessen an den Erwartungen schwächsten Mannschaften der abgelaufenen Saison. Das unterdurchschnittliche Abschneiden kostete die Grazer letztlich einen Europacupplatz, damit dringend benötigte Einnahmen und kann dafür sorgen, dass man in eine Abwärtsspirale gerät (je weniger Einnahmen, desto weniger sportlicher Erfolg, desto weniger Einnahmen aus Sponsorverträgen und Europacup, etc). Die Mittelständer Wolfsberg, Ried und Altach, die während der Saison zum Teil auch erhebliche Probleme hatten, konnten sich letztlich relativ ungefährdet in der Liga halten.

Mattersburg ist wiederum ein interessanter Fall. In meinem Modell ist es der am schwächsten abschneidende Klub, was daran liegt, dass das Modell Aufsteiger anders beurteilt als andere Teams, da diese in der Vergangenheit besser als erwartet abschnitten und deshalb das Modell durch diese Ungleichbehandlung verbessert werden konnte, was letztlich immer das Ziel ist. Es wird deshalb interessant sein, zu sehen, ob Mattersburg ein Ausreißer in der Reihe der positiven Aufsteiger der vergangenen Jahre ist oder ob diese Serie nicht doch eher dem Zufall entsprang. Allein von seinem Durchschnittsmarktwert her hat Mattersburg nämlich im Grunde die Punkteanzahl erreicht, die man vermuten könnte.

Am Tabellenende steht Grödig, das nur wenig unter der Punkteprognose landete, was letztlich aufgrund eines mangelnden anderen Underperformers aus der Gruppe der Nachzügler der Plätze 6-9 nicht zum Klassenerhalt reichte.

Den Vergleich zwischen erwartbaren und tatsächlich erreichten Punkten kann man auch für die verantwortlichen Trainer anstellen. Unterschiede zwishen Graphik 1 und Graphik 2 ergeben sich also bei den Vereinen, die im Laufe der abgelaufenen Saison mehr als einen Trainer in Amt und Würden hatten, bei allen anderen ist das Ergebnis für den Trainer logischerweise gleich wie für den Klub insgesamt. Um die Werte vergleichbar zu machen, sind nicht mehr absolute, sondern Durchschnittswerte angegeben.

Die Trainer in Graphik 2 sind nach der Anzahl an durchschnittlich geholten Punkten geordnet und nicht nach prognostizierten. Dennoch sind die drei in Salzburg tätig gewesenen Cheftrainer im Ranking ganz vorne, holten im Schnitt also am meisten Punkte. Dennoch zeigt sich, dass die Mannschaft unter Zeidler leicht unterdurchschnittlich abschnitt, weshalb seine Freistellung zumindest aufgrund der Resultate gerechtfertigt erscheint.

Danach folgen die Coaches der beiden Wiener Klubs, die wie bereits erwähnt besser als erwartet abschnitten (was die Trennung Rapids von Barisic zweifelhaft erscheinen lässt, zumindest aus sportlicher Sicht), und die Trainer der beiden positiven Überraschungen der abgelaufenen Saison, dem WAC nach dem Trainerwechsel (ein klassisches Beispiel der Regression zum Mittelwert) und der Admira.

Insgesamt zeigt sich, dass die meisten Trainer in etwa im erwartbaren Bereich abschneiden, was sich mit bisherigen Unterscuhungen deckt: Die meisten Chefcoaches haben weder einen besonders positiven noch einen besonders negativen Einfluss auf die Ergebnisse ihrer Mannschaften. Diejenigen Coaches, die jedoch die Erwartungen deutlich untererfüllen, werden meist schnell freigesetzt. Von den vier Trainern, die in der abgelaufenen Saison deutlich unter dem Konfidenzintervall liegen, überlebt nur einer (der Sonderfall Vastic) die Saison. Die anderen drei wurden bereits während der Herbstsaison entlassen.

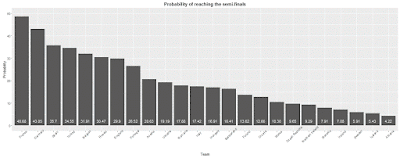

Zuletzt kann man das Modell auch heranziehen, um die Punkte für die kommende Saison zu prognostizieren (siehe Graphik 3). Allen voran ist auch diesmal wieder Meister Salzburg zu erwarten, deren unteres Ende des Konfidenzintervalls noch weit vor der Konkurrenz liegt. Das Modell sagt also mit einer 95%igen Wahrscheinlichkeit eine Titelverteidigung voraus. Dahinter folgen wie in der vergangenen Saison die beiden Wiener Vereine in der gleichen Reihenfolge wie sie auch 2015/16 abschlossen.

Dahinter folgt bereits Aufsteiger St. Pölten. Wie bereits die vergangenen Jahre bewertet das Modell den Aufsteiger besser als andere Klubs mit vergleichbarem Marktwert, da diese in den vergangenen Jahren vor Mattersburg weit besser als erwartet abschnitten. Ob diese Entwicklung bereits beendet ist oder weiterhin besteht und Mattersburg nur eine Ausnahme war, wird sich erst weisen. Das breite Konfidenzintervall zeigt auf jeden Fall, dass für die Niederösterreicher einiges drinnen ist: Ein Rückfall ins hintere Mittelfeld ist genauso drinnen wie ein Angriff auf die Europacupplätze. Nur mit dem Abstieg sollte man die nächsten beiden Saisonen nichts zu tun haben.

Dahinter folgt Sturm, das wohl wie im letzten Jahr die Europacupplätze verpassen wird. Die Einschätzung des runderneuerten Kaders lässt die Punkteprognose im Vergleich zum Vorjahr um etwa sieben Punkte zurückgehen, was nur für das Tabellenmittelfeld reichen wird. Hinter den Grazern beginnt bereits die Abstiegszone, in der sich fünf Teams innerhalb eines Bereichs von circa zwei Punkten tummeln. Die Reihenfolge innerhalb der Plätze sechs bis zehn ist also höchst unsicher, schon kurze Stärke- oder Schwächephasen können massive Auswirkungen auf das Endergebnis haben. Die Liga verspricht einen Abstiegskampf auf Messers Schneide.

Den Vergleich zwischen erwartbaren und tatsächlich erreichten Punkten kann man auch für die verantwortlichen Trainer anstellen. Unterschiede zwishen Graphik 1 und Graphik 2 ergeben sich also bei den Vereinen, die im Laufe der abgelaufenen Saison mehr als einen Trainer in Amt und Würden hatten, bei allen anderen ist das Ergebnis für den Trainer logischerweise gleich wie für den Klub insgesamt. Um die Werte vergleichbar zu machen, sind nicht mehr absolute, sondern Durchschnittswerte angegeben.

|

| Graphik 2 |

Danach folgen die Coaches der beiden Wiener Klubs, die wie bereits erwähnt besser als erwartet abschnitten (was die Trennung Rapids von Barisic zweifelhaft erscheinen lässt, zumindest aus sportlicher Sicht), und die Trainer der beiden positiven Überraschungen der abgelaufenen Saison, dem WAC nach dem Trainerwechsel (ein klassisches Beispiel der Regression zum Mittelwert) und der Admira.

Insgesamt zeigt sich, dass die meisten Trainer in etwa im erwartbaren Bereich abschneiden, was sich mit bisherigen Unterscuhungen deckt: Die meisten Chefcoaches haben weder einen besonders positiven noch einen besonders negativen Einfluss auf die Ergebnisse ihrer Mannschaften. Diejenigen Coaches, die jedoch die Erwartungen deutlich untererfüllen, werden meist schnell freigesetzt. Von den vier Trainern, die in der abgelaufenen Saison deutlich unter dem Konfidenzintervall liegen, überlebt nur einer (der Sonderfall Vastic) die Saison. Die anderen drei wurden bereits während der Herbstsaison entlassen.

|

| Graphik 3 |

Dahinter folgt bereits Aufsteiger St. Pölten. Wie bereits die vergangenen Jahre bewertet das Modell den Aufsteiger besser als andere Klubs mit vergleichbarem Marktwert, da diese in den vergangenen Jahren vor Mattersburg weit besser als erwartet abschnitten. Ob diese Entwicklung bereits beendet ist oder weiterhin besteht und Mattersburg nur eine Ausnahme war, wird sich erst weisen. Das breite Konfidenzintervall zeigt auf jeden Fall, dass für die Niederösterreicher einiges drinnen ist: Ein Rückfall ins hintere Mittelfeld ist genauso drinnen wie ein Angriff auf die Europacupplätze. Nur mit dem Abstieg sollte man die nächsten beiden Saisonen nichts zu tun haben.

Dahinter folgt Sturm, das wohl wie im letzten Jahr die Europacupplätze verpassen wird. Die Einschätzung des runderneuerten Kaders lässt die Punkteprognose im Vergleich zum Vorjahr um etwa sieben Punkte zurückgehen, was nur für das Tabellenmittelfeld reichen wird. Hinter den Grazern beginnt bereits die Abstiegszone, in der sich fünf Teams innerhalb eines Bereichs von circa zwei Punkten tummeln. Die Reihenfolge innerhalb der Plätze sechs bis zehn ist also höchst unsicher, schon kurze Stärke- oder Schwächephasen können massive Auswirkungen auf das Endergebnis haben. Die Liga verspricht einen Abstiegskampf auf Messers Schneide.